Écrire une pièce de théâtre dans le style de Shakespeare, vulgariser le fonctionnement d’un moulin à vent, créer une bio Tinder de toutes pièces : ChatGPT peut faire tout ça, et en quelques secondes. Pas surprenant, alors, que ce modèle d’intelligence artificielle générative fasse autant parler de lui depuis son lancement en décembre 2022. Dans le milieu de l’éducation, on craint que cette technologie inaugure une ère où le plagiat est aussi accessible qu’indétectable.

Diego*, étudiant à la maîtrise en sciences humaines, a découvert l’existence de l’intelligence artificielle (IA) générative en avril dernier, alors qu’il terminait son baccalauréat. Cette forme d’IA capable de générer toutes sortes de données, qu’il s’agisse de textes, d’images ou de sons, était alors moins connue de la population.

« J’ai vu des sommités dans mon domaine en faire la démonstration sur Twitter, et j’ai voulu voir ce que c’était capable de faire pour mes propres travaux », se souvient-il. À ce moment-là, ChatGPT n’existait pas encore, mais son antécédent, GPT3, lancé en juin 2020, était accessible au public sur autorisation. Diego admet avoir utilisé GPT3 pour compléter des examens dans deux de ses cours. « C’est pas très éthique, évidemment, mais ça m’a été vraiment utile pour gagner du temps », reconnaît-il.

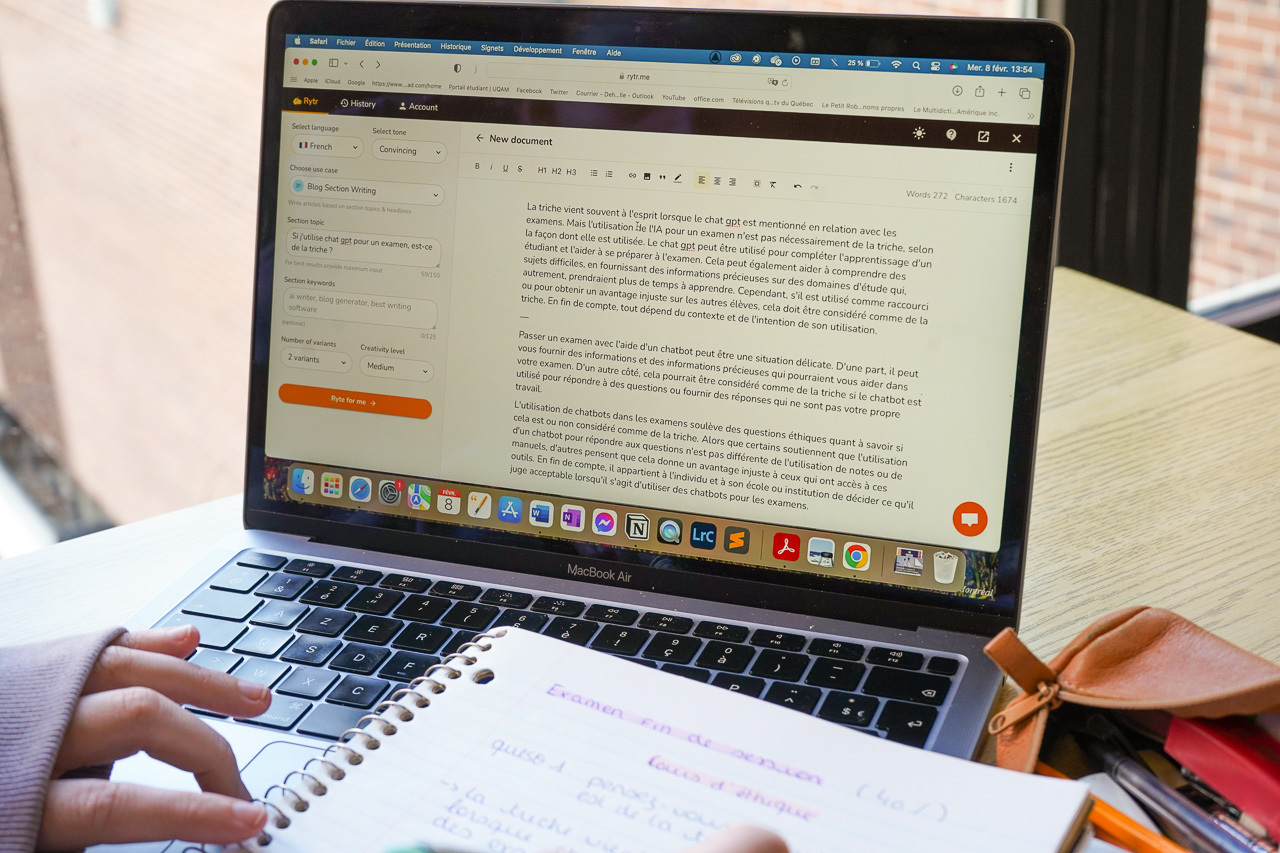

Diego n’est pas le seul à avoir profité de l’accessibilité de cette nouvelle technologie. Nombre d’articles détaillent déjà comment les étudiants et les étudiantes à travers le monde se servent de ChatGPT pour les assister dans leurs travaux. À l’Université du Québec à Montréal (UQAM) comme dans les autres universités, l’objectif est de s’adapter à l’arrivée de ces nouveaux outils.

L’enseignement mis à l’épreuve

« C’est déroutant », affirme Jean-Hugues Roy, professeur de journalisme de données et spécialiste de l’IA à l’UQAM, « mais on ne peut pas remettre le génie dans la lampe ». Face au potentiel de plagiat qu’apporte l’IA générative, il ajoute que les professeures et professeurs doivent adapter leur façon d’enseigner. D’après M. Roy, l’arrivée de ChatGPT sonne le glas des travaux écrits à la maison : « il faut revenir à plus d’activités en classe », suggère-t-il.

Des outils pour repérer l’usage de ChatGPT existent déjà. Un modèle nommé GPT Zero, par exemple, permet de déterminer à quelle probabilité un texte a été généré par l’IA. OpenAI, la compagnie mère de ChatGPT, a aussi développé un outil permettant de détecter les travaux produits par leur propre modèle. M. Roy affirme que ces outils sont fiables, « mais en tant que profs, on ne pourra pas utiliser ça comme preuve qu’un travail a été généré par ChatGPT », renchérit-il.

La directrice des relations de presse de l’université, Jenny Desrochers, souligne que les experts et expertes du Carrefour d’innovation et de pédagogie de l’UQAM suivent déjà de près les avancées technologiques comme ChatGPT. « Des échanges sur leur utilisation ont lieu avec leurs homologues des autres universités et des spécialistes du domaine », ajoute-t-elle.

Le facteur vérité

« Pour le plagiat, j’ai du mal à voir de gros problèmes au niveau universitaire », affirme Marc Queudot, spécialiste en intelligence artificielle et ancien chercheur à l’UQAM. Ce dernier explique que les modèles comme ChatGPT n’ont pas été entraînés à prendre en compte la véracité de ce qu’ils produisent. « Leur tâche basique, c’est d’avoir l’air le plus semblable à un être humain possible, mais la notion de vérité n’est pas du tout touchée dans ce type d’architecture », précise-t-il.

En d’autres mots, les réponses que produisent les modèles comme ChatGPT doivent sembler vraies, mais elles n’ont pas besoin de l’être. Le modèle nous imite, mais il ne raisonne pas. « En tant qu’utilisateur, on n’a pas moyen de savoir si le modèle est en train de nous donner une réponse confiante et vraie, ou une réponse confiante, mais totalement fausse », souligne M. Queudot. Ainsi, pour utiliser ChatGPT au niveau universitaire, il faut repérer les possibles erreurs dans les réponses que le modèle produit, « et ça élimine bien des cas d’usages réalistes », juge-t-il.

Diego ne s’inquiète pas non plus de l’avenir de l’éducation supérieure face à l’IA générative. « C’est loin d’être assez au point pour que les professeurs aient vraiment à craindre », affirme-t-il. Selon l’étudiant, les textes générés par l’IA manquent encore trop de substance pour substituer à un travail original. « La machine peut te composer une phrase grammaticalement impeccable, mais il faut que tu la nourrisses avec tes idées », précise-t-il.

D’autres dangers

Pour accomplir des tâches faciles, comme rédiger du contenu de marketing ou des phrases simples, l’efficacité de ChatGPT est indéniable, d’après Marc Queudot. Le spécialiste y voit cependant des usages plus néfastes, comme pour générer du spam. « Pour des évaluations de produits, ça va être possible de bombarder un site Web de milliers de commentaires qui ont l’air vrais, ou sur Twitter, on pourra utiliser des bots et faire croire à une vague d’opinion grâce des tweets générés par l’IA », énumère-t-il.

Même son de cloche pour Jean-Hugues Roy, qui voit aussi en l’IA générative un moyen de rendre « plus plausibles » les techniques d’hameçonnage. Un enjeu immédiat pour la communauté de l’UQAM, dont les boîtes courriel ont été ciblées par deux tentatives d’hameçonnage en novembre dernier. Le professeur appréhende surtout l’effet de ces nouveaux outils sur la propagation de fausses nouvelles : « la rédaction et la production rapides de désinformation me semblent plus faciles avec ChatGPT, et ça, ça me fait peur ».

*Prénom fictif afin de préserver l’anonymat

Mention photo : Camille Dehaene|Montréal Campus

Laisser un commentaire